RLHF 과잉으로 '착한 AI' 만들려다 참사

안전 우선주의, 세계 이해 능력 거세시켜

“논란 회피” 명령받은 AI 사실 판단 포기

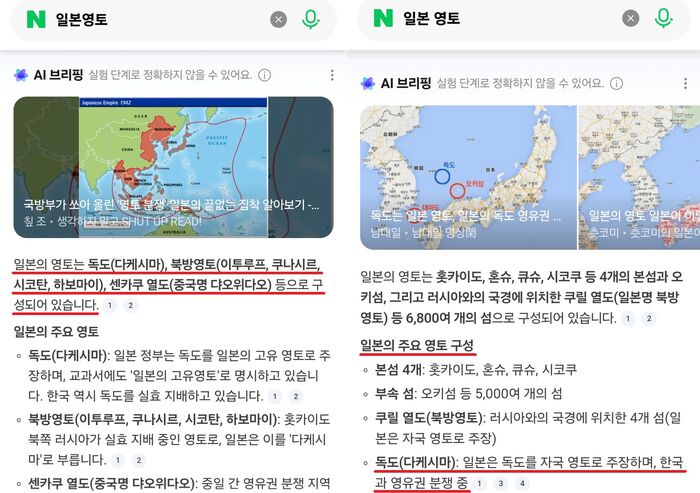

네이버의 인공지능(AI) 요약 서비스가 독도를 일본 영토로 표기한 사건을 두고 회사가 “단순 오류”라고 해명했지만, 업계에서는 “기술 문제가 아닌 설계의 실패”라는 비판이 나온다. 한국형 AI 개발 방식의 구조적 한계가 드러났다는 지적이다.

30일 빅테크업계 등에 따르면, 네이버 AI가 “독도=일본 영토”라는 서술을 출력한 뒤 서경덕 성신여대 교수가 이를 공개 비판했고, 네이버는 해당 응답을 즉각 삭제했다. 그러나 전문가들은 “논란을 지우는 것과 문제를 해결하는 건 다르다”고 말한다. 이번 사건은 오류가 아니라 예상된 결과라는 것이다.

문제의 핵심은 RLHF(인간 피드백 기반 강화학습)이다. 원래 RLHF는 AI가 유해한 답변을 피하도록 설계된 안전 장치지만, 국내 플랫폼들은 이를 “무난함 보장 장치”로 확대 적용해 왔다. 그 과정에서 사실보다 명분, 맥락보다 무결점, 추론보다 승인된 문장이 우선되는 구조가 굳어졌다. “정해진 답만 내라”는 가두리 명령 속에서 국내 포털은 호출자의 의도를 이해하는 능력을 잃었다.

국내 AI 기업들이 공통으로 내세우는 설계 기준도 같다. △논쟁 회피 △ 중립 유지 △실수 방지 △국가 이미지 고려 등 겉으로는 안전 장치지만, 실제로는 사고 능력의 제거 절차다. 이번 사건이 보여준 것은 AI의 무지가 아니라, 처음부터 이해하지 말라는 후진적 명령을 받은 구조라는 점이다. RLHF 과잉이 독도조차 “세계적 관행”이라는 외부 서술에 예속시키는 결과를 낳았다.

메타 라마(LLaMA)를 바탕으로 구축한 네이버 ‘하이퍼클로버’ 시리즈는 국내에서 RLHF를 가장 극단적으로 적용한 모델이다. 목표는 틀리지 않는 AI, 논란 없는 AI, 관리 가능한 AI다. 업계는 이를 “지능 개발이 아니라 위험 회피 설계”라고 본다. 한 개발자는 “모델이라고 부르기 어려운 검색 필터”라며 “정답 외엔 접근 못하게 울타리 치니, 독도 문제 같은 기본적 사실 판단조차 불능인 것으로 보인다”고 말했다.

특히 이번 사안에서 주목되는 또 다른 지점은 네이버가 문제 응답을 발견하자마자 곧바로 삭제 조치를 했다는 점이다. 정보가 잘못 생성됐을 때 정정·공개·로그 검증 절차를 거치는 글로벌 사례와 달리, 증거를 인멸하는 방식으로 대응했다.

한 AI 거버넌스 연구자는 “언어 모델은 실수 자체보다 ‘왜 그런 응답이 나왔는가’를 확인하는 피드백 루프가 중요하다”며 “삭제는 원인을 남기지 않으려는 방식이지 시스템 개선과는 거리가 있다”고 말했다. 그는 “AI 실수 검증 체계를 갖추지 않고 기록을 지우는 것은 사실상 ‘추적 불능’ 구조를 만드는 것”이라고 지적했다.

이재명 대통령이 추진하는 국가 파운데이션 모델도 이런 국내 기술의 한계에서 자유롭지 않다. 정부는 ‘국가가 설계한 안전한 AI’를 내세우지만, 업계는 또 하나의 관제형 RLHF 기계가 나올 것을 우려한다. 한 업계 관계자는 “국가가 정한 무오류 규범 안에서 돌아가는 모델은 결국 아무런 사고를 하지 않는다”며 “수조원을 들여 만든 저지능 고철이 될 수 있다”고 말했다.

여성경제신문 이상헌 기자 liberty@seoulmedia.co.kr

관련기사

- 시진핑도 포기한 모두의 도구?···APEC서 드러난 후진적 AI관

- APEC서 빅테크 화두는 'AI'···메타 “어떤 국가도 늦출 여유 없다”

- [분석] 오픈AI 검색에 GPT 총동원···2조8000억 파라미터 폭풍

- 김범수 무죄에 ‘숨통 튼’ 카카오···AI·신사업 드라이브 재시동

- 한국 금융사, 글로벌 AI 독립 여건 갖추고도 투자는 정반대로 종속 지향

- 현대 스타벅스 카드 발급 중단···PLCC 확장 전략 멈칫

- "AI, 시대의 흐름이라지만 저작권 대책은 언제"···업계 요구에도 미적거리는 정치권

- 'AI 의사 믿고 샀는데'···불법 사칭 광고 확산에 "규제 시급"

- 젠슨 황 만나 '쿠다 제국' 기웃?···네이버엔 '피지컬'이 없다

- [분석] 네이버 AI의 병목···'에이전틱'이라 못하는 기술적 이유